Az MI rendszerek használata kapcsán az egyik gyakran emlegetett kihívás az átláthatóság kérdése. Sokszor merül fel kritikaként ugyanis, hogy a modellek működése egy ún. "fekete doboz" (black box), nem tudjuk, illetve sokszor nem értjük pontosan mi játszódik le a "motorháztető alatt".

Az MI alkalmazásával kapcsolatban azonban felmerül egy más jellegű transzparencia probléma is: az MI rendszereket fejlesztő - jellemzően nagy technológiai vállalatok - nem mindig tesznek meg mindent azért, hogy átláthatóvá tegyék a modelljeik működését, megfelelően tájékoztatássák az érintetteket. Ez a tendencia ráadásul, az utóbbi időben az éleződő verseny miatt, tovább erősödött, amelynek a szélesebb közvélemény is kárát látja, hiszen az MI megoldások használatának rohamos terjedését tapasztalhatjuk, mindeközben egyre kevésbé láthatjuk át, mi is történik valójában, milyen adatokkal tanították a rendszert, miként kezelik az adatokat, hogyan jön létre az a kimeneti eredmény, amellyel találkozunk.

Az OpenAI például kifejezetten deklarálta, hogy a GPT-4 esetében már nem ad érdemi információkat a technikai részletekről: "Tekintettel az éleződő versenyre és a biztonsági megfontolásokra az olyan nagy méretű modellek, mint a GPT-4 tekintetében [...] nem teszünk közzé további részleteket az architektúrára (beleértve a modell méretét), a hardverre, a tréningezésnél használt számítási kapacitásra, az adatbázis összetételére, a tanítási metodológiára vagy hasonló kérdésekre vonatkozóan."

Az OpenAI felől érkező kihívásra válaszul a Google is úgy döntött, hogy - szakítva a korábbi gyakorlatával - kevesebb információt tesz elérhetővé a házon belül zajló MI fejlesztésekről.

Az átláthatóság csökkenése ugyanakkor azon szervezeteket is kellemetlenül érinti, amelyek ezen modellekre építve fejlesztenek saját rendszereket, folyamatokat, illetve szolgáltatásokat.

Mit nevezünk alapmodellnek?

A készülő EU-s MI rendelet Európai Parlament által a trilógushoz javasolt kompromisszumos szövegváltozata az alábbi definíciót tartalmazza (ez természetesen még változhat, akár ki is kerülhet a végleges szövegből):

Alapmodell (foundation model): olyan nagy mennyiségű adathalmazon betanított MI-modell, amelyet a kimenet általánosságára terveztek és számos különböző feladat ellátásához adaptálható; angolul: "AI model that is trained on broad data at scale, is designed for generality of output, and can be adapted to a wide range of distinctive tasks", 3. cikk, 1c. pont),

Generatív MI: az alapmodell alkategóriája, amelyet kifejezetten tartalom, például összetett szövegek, képek, hang vagy videó, előállítására szánt MI rendszerekben - különböző szintű autonómiával - használnak; angolul: "foundation models used in AI systems specifically intended to generate, with varying levels of autonomy, content such as complex text, images, audio, or video", 28b. cikk 4. pont).

(A Parlament szövegjavaslatáról itt írtam korábban.)

A Stanfordi Egyetem kifejlesztett és közzétett egy, az alapmodellek (foundation models) átláthatóságát több, mint 100 szempont alapján vizsgáló módszertant, amely alapján egy átláthatósági index ("Foundation Model Transparency Index") ad képet a különböző, további kereskedelmi felhasználásra kerülő modellek transzparenciájáról. Az értékeléshez használt metodológiát egy részletes publikációban mutatják be, amely szintén szabadon hozzáférhető.

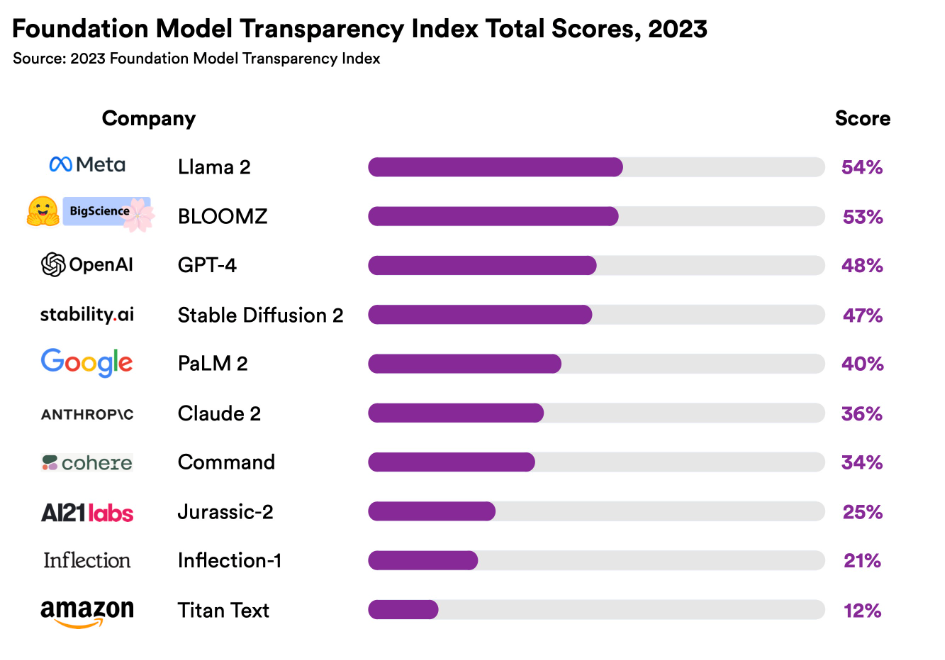

Az első értékelés alapján a kép nem túl biztató: a 10 legnagyobb szolgáltató vizsgált alapmodelljei esetében a 100 pontos skálán a legjobb eredmények is éppen csak meghaladják az 50%-ot, míg a sereghajtók ettől is messze elmaradnak:

A vizsgálat főbb megállapításai tehát az alábbiak:

- Az átlagos érték 37% lett, míg a legmagasabb pontszám 54%, ami azt mutatja, hogy nem egyedi, hanem szektorális jelenségről van szó. Mindegyik szolgáltató jelentős elmaradásban van a transzparenciát illetően.

- A nyílt forráskodú MI-modellek mutatnak nagyobb átláthatóságot (a listában szereplő három nyílt forráskodú modell: Llama 2, BLOOMZ, Stable Diffusion 2).

- Az értékeléshez használt 100 szempont közül legalább 82-nek valamely szolgáltató meg tudott felelni, így önmagában a jó gyakorlatok átvétele révén jelentős javulás lenne elérhető a szektorban.

De mit is vizsgáltak a modellek átláthatósága kapcsán?

A vizsgálat összesen 100 indikátor alapján értékelte a modelleket (az indikátorok listája elérhető ezen az oldalon). Az indikátorok három kategóriába sorolhatók:

- upstream: lényegében a modell fejlesztésével kapcsolatos szempontok,

- modell: a modellre vonatkozó szempontok (pl. architektúra, képességek, kockázatok),

- downstream: a modell használatát érintő kérdések (pl. a felhasználókra gyakorolt hatás).

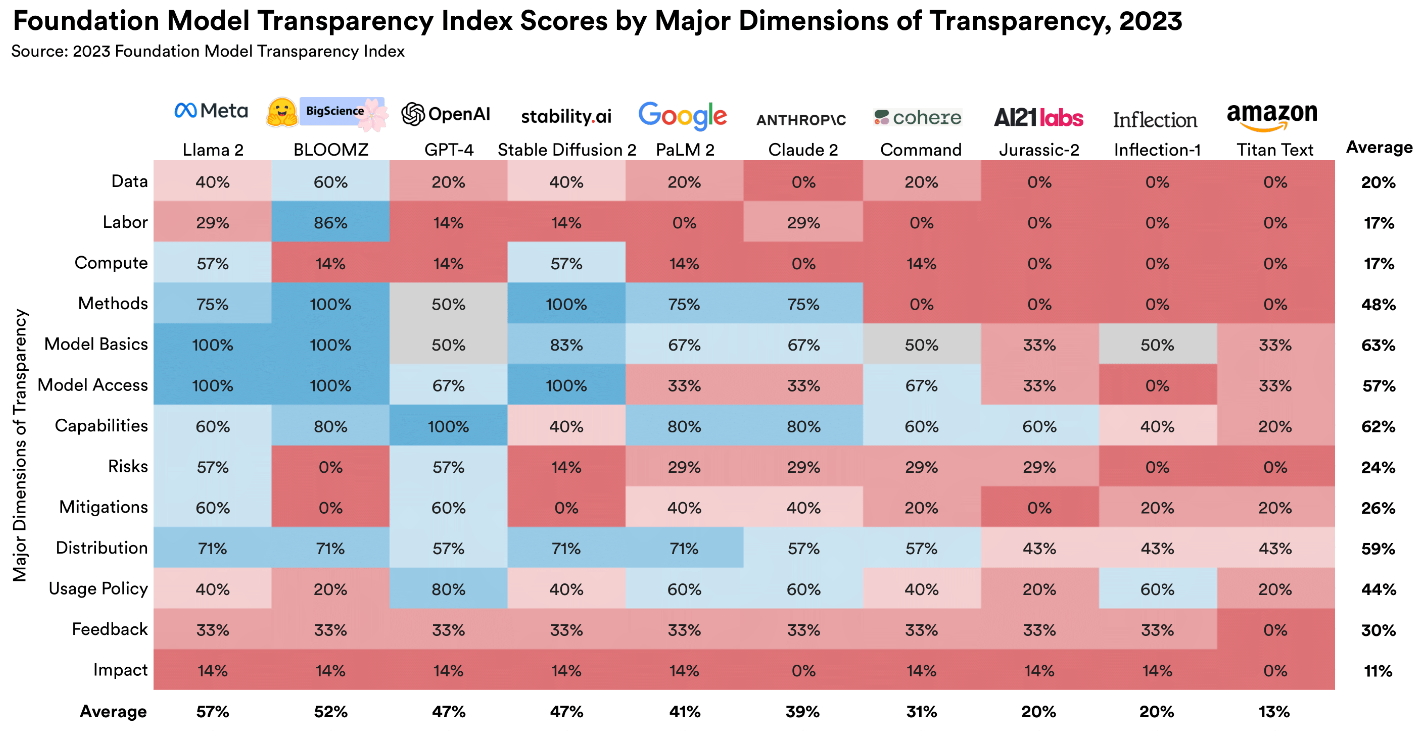

Az alábbi ábra betekintést ad a részletekbe és látható, hogy egyes témák kapcsán (pl. hatás, visszajelzések) szélesebb körben mutatkoznak komoly elmaradások:

Ajánlások az elemzés alapján

A kutatás eredményeként több ajánlás is megfogalmazásra került egyrészt a fejlesztők (developer), másrészt a modelleket felhasználó, azokat a termékeikbe, szolgáltatásaikba beépítő szervezetek (deployer) felé, továbbá a szabályozók irányába is. (Lásd a módszertant is részletesen bemutató tanulmány 8. pontját.)

Javaslatok fejlesztők részére:

- A meglévő modellek átláthatóságának javítása: (i) több információ megosztása a már elérhető modellekről, (ii) a fejlesztőknek a könnyen elérhető eredményekre ("law-hanging fruits") kellene elsősorban koncentrálniuk, amivel gyors eredményt érhetnének el: a nehezen követhető nyelvezetű dokumentációik frissítésével, a meglévő információforrások centralizálása révén és információkat kellene megosztaniuk azon modellek tekintetében, amelyek esetében ez nem jár jelentős versenyképességi vagy jogi kockázatokkal (itt jó példaként említi a tanulmány az Anthropic-ot, amely a Claude 2 tekintetében jóval több információt osztott meg, mint a korábbi modellje esetében). Szintén fontos lenne, hogy a fejlesztő cégek világosan kommunikáljanak arról, ha valamely részterület kapcsán nem akarnak megosztani információt, megjelölve ennek az okát is.

- A jövőbeni modellek átláthatóságának javítása: fontos lenne, hogy az indexben szereplő 100 indikátor tekintetében megfelelő információkat osszanak meg a fejlesztők, illetve ezen túlmenően minden olyan szempont kapcsán, amelyet fontosnak tartanak a modelljük kapcsán. Az információmegosztás ellen szóló gyakori érvre tekintettel, miszerint az információk megosztása az adott fejlesztő versenyképességét veszélyezteti, célszerű lehet külső harmadik felet bevonni annak mérlegelésébe, hogy a meglévő profitelvárások és a modell társadalomra gyakorolt hatása között hogyan teremthető egyensúly. Az önkéntes, harmadik fél (független auditor) által végzett auditok nagyban hozzájárulhatnak a transzparencia javulásához, egyúttal a versenyképesség megóvásában is segíthetnek, hiszen a kényes információk megfelelő szerződéses garanciákkal védetté tehetők. Ugyanakkor - teszi hozzá a tanulmány - az auditok nem képesek minden esetben kiváltani az információk nyilvánosságra hozatalát és az ezt követően meginduló nyilvános eszmecserét.

- Iparági legjobb gyakorlatok követése az átláthatóság érdekében.

- Együttműködés a modellekre építő szolgáltatókkal (alkalmazó, deployer) az átláthatóság érdekében.

- Együttműködés a modellen további fejlesztést, finomhangolást végző fejlesztőkkel (downstream developer) a transzparencia javítása érdekében (pl. dokumentáció rendelkezésre bocsátása).

- Együttműködés a szabályozókkal a nagyobb átláthatóság érdekében.

- Az átláthatóság felhasználása a hosszabb távú előnyök, így a bizalom, biztonság és megbízhatóság erősítése érdekében.

- Az átláthatóság folyamatos javításához szükséges erőforrások biztosítása.

- A teljes alapmodell fejlesztő ökoszisztémán belüli transzparencia fejlesztése. (Ebbe a körbe tartozhat pl. az egyértelmű verziókövetés, illetve az újabb verziókra való átállás időben történő kommunikálása. Fontos lehet továbbá a dependeciákról való világos tájékoztatás.)

- A Foundation Model Transparency Index felhasználása az átláthatóság javítására. (A kidolgozott, részletes taxonómiát használhatják a fejlesztők arra, hogy a saját modelljeiket ennek megfelelően értékeljék és azonosítsák az esetleges hiányosságokat.)

Javaslatok alkalmazók (deployer) részére:

- Kockázatelemzés elvégzése annak megítélésére, hogy milyen hatása lehet a nem kellően átlátható alapmodellek alkalmazásának.

- Az alapmodell fejlesztők felé is szükséges érvényesíteni az alkalmazók transzparenciával kapcsolatos elvárásait.

- A modelleket alkalmazók nem bízhatnak meg vakon a fejlesztőkben, legyenek azok bármilyen nagy, jónevű cég égisze alatt.

A Stanford átláthatósági indexe képet ad arról, hogy jelenleg hogyan állnak a legfontosabb piaci szereplők az alapmodelljeik transzparenciája kapcsán. Ha az értékelés a részletesen kidolgozott szempontrendszer alapján újra és újra elkészül majd, akkor nagyon jó áttekintést adhat a modellek átláthatósága kapcsán történő esetleges változásokról. Remélhetőleg az index ösztönzést is jelent majd a modellek fejlesztőinek, hogy törekedjenek a minél nagyobb transzparenciára mind a modellek fejlesztési, mind felhasználási időszakában.